Europa przyspiesza z budową infrastruktury AI, a istotną rolę odgrywają tu najwięksi europejscy operatorzy telekomunikacyjni, mówił Carlo Ruiz, VP AI Solutions & Operations EMEA, Nvidia podczas konferencji Vertiv Week 2025 w Tognanie we Włoszech. Wśród aktywnych inwestorów wymienił: Deutsche Telekom, Orange, Telefónica, Telenor, Swisscom czy Fastweb. Dzięki rozbudowanej infrastrukturze światłowodowej, centrom danych i zasobom energetycznym, operatorzy ci współtworzą podstawy pod rozwój AI w Europie. Ich rola nie ogranicza się jedynie do transmisji danych – coraz częściej inwestują oni w wyspecjalizowane centra obliczeniowe GPU. Przypomnijmy, Deutsche Telekom i Nvidia 4 listopada br. ogłosiły budowę jednej z największych w Europie fabryk sztucznej inteligencji – Industrial AI Cloud – o wartości około 1 mld euro.

Intensywny rozwój infrastruktury AI w Europie jest realizowany także przez sieć europejskich superkomputerowych centrów danych, wśród których ekspert Nvidii wymienił m.in. Poznańskie Centrum Superkomputerowo-Sieciowe (Fabryka Piast-AI). Kolejna grupa intensyfikująca swoje działania na rzecz rozwoju infrastruktury AI w ramach europejskiej strategii cyfrowej wskazana przez Ruiza, to dostawcy usług chmurowych, w tym m.in. Beyond.pl, OVHcloud czy T-Systems.

Według prognoz zaprezentowanych przez Carlo Ruiza, europejski rynek infrastruktury AI czeka 10-krotny wzrost mocy obliczeniowej do 2028 r. Szacunki oparte na analizie rozwoju centrów danych GPU w regionie EMEA wskazują, że do końca 2025 r. wolumen obliczeń potroi się w porównaniu z rokiem 2023, a w ciągu kolejnych trzech lat osiągnie poziom dziesięciokrotnie wyższy.

Tak dynamiczny przyrost mocy jest wynikiem rosnącego zapotrzebowania na przetwarzanie danych generowanych przez modele AI, uczenie maszynowe i analitykę w czasie rzeczywistym. Europa – choć startowała później niż Stany Zjednoczone czy Chiny – coraz szybciej nadrabia dystans dzięki wspólnym inwestycjom w infrastrukturę obliczeniową i energetyczną.

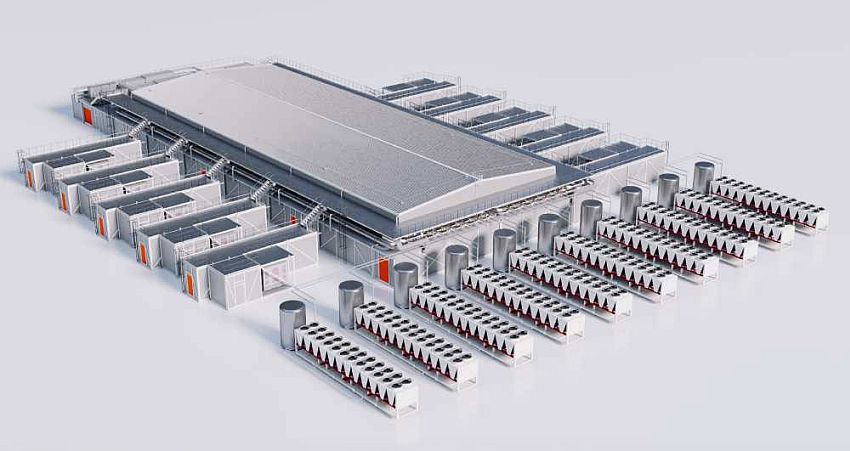

Gio Albertazzi, CEO Vertiv podczas konferencji powiedział, że obserwujemy stałe przyspieszenie w budowie prefabrykowanych, modularnych centrów danych, które pozwalają spełniać wymagania najnowszej generacji układów scalonych, technologii i usług. Podkreślił, że dynamiczny rozwój ekosystemu AI wzmacnia pozycję Vertiv, jako dostawcy infrastruktury dla centrów danych dedykowanej AI. Według CEO Vertiv, branża będzie rozwijać się na dwóch płaszczyznach: tradycyjnej, która nadal będzie istotna, oraz drugiej, która przyspieszy dzięki prefabrykowanym, pełnowymiarowym rozwiązaniom gigawatowym.

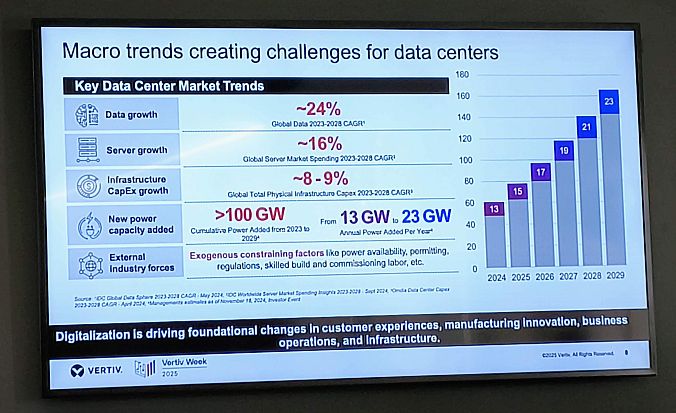

Według danych prezentowanych przez Vertiv, globalna ilość danych w latach 2023–2028 będzie rosnąć w tempie około 24 proc. rocznie (CAGR), podczas gdy wydatki na serwery zwiększają się o 16 proc. rocznie. Nakłady inwestycyjne (CapEx) na fizyczną infrastrukturę centrów danych, choć również rosną, utrzymują się na znacznie niższym poziomie (8–9 proc. CAGR), co wskazuje na rosnącą presję kosztową i potrzebę optymalizacji inwestycji.

Według prognoz IDC, światowy rynek infrastruktury dla sztucznej inteligencji (AI) osiągnie wartość 758 mld dolarów do 2029 r. Tylko w 2. kw. 2025 r. wydatki na sprzęt obliczeniowy i pamięci masowe na potrzeby wdrożeń AI wzrosły o 166 proc. r/r, osiągając poziom 82 mld dolarów. Największy udział w tych inwestycjach mają serwery z wbudowanymi akceleratorami, które stanowią obecnie 91,8 proc. wydatków na infrastrukturę serwerową AI. IDC prognozuje, że do 2029 r. ich udział wzrośnie do ponad 95 proc., przy średniorocznym tempie wzrostu (CAGR) na poziomie 42 proc.

Sztuczna inteligencja jest paliwem dla rozwoju infrastruktury centrów danych, podkreślał Karsten Winther, prezes regionu EMEA w Vertiv. W ramach swojej prezentacji przedstawił prognozę rozwoju infrastruktury centrów danych w kontekście rosnących wymagań obliczeniowych i gęstości mocy dla akceleratorów Nvidia. I tak przewiduje się, że w ciągu najbliższych 5 lat zapotrzebowanie na moc w ramach jednego racka serwerowego wzrośnie z 70 kW (generacja Hopper, 2023) do nawet ponad 390 kW w 2028 r., co przekłada się na wzrost gęstości mocy całych modułów obliczeniowych (POD) do poziomu 6,3 MW.

„Jednostką obliczeniową (compute unit) nie jest już chip. Obecnie to cały system. To fabryka AI”, można było przeczytać na jednym ze slajdów prezentacji Karstena Winthera, zatytułowanym: „Nowy paradygmat ‘jednostki obliczeniowej’: obiekt o mocy 400 MW (do trenowania)”.

Do 2029 roku planowane jest dodanie ponad 100 GW nowej mocy obliczeniowej, z rocznym przyrostem, zwiększającym się z 13 GW do 23 GW. Jednocześnie branża mierzy się z rosnącymi ograniczeniami zewnętrznymi. Dostępność energii, presja regulacyjna oraz niedobór wykwalifikowanej kadry do budowy i uruchamiania obiektów, to kluczowe czynniki spowalniające ekspansję sektora.

Prognozy Vertiv pokazują, że ewolucja centrów danych w kierunku rozwiązań o ekstremalnej gęstości mocy wymagać będzie nowego podejścia do infrastruktury energetycznej i systemów chłodzenia – kluczowych dla utrzymania efektywności w erze zaawansowanych akceleratorów AI.

Według przytoczonych na konferencji danych Yahoo Finance i „Financial Times”, globalne wydatki branży technologicznej na infrastrukturę do trenowania modeli AI osiągnęły już 350 mld dolarów, a do końca 2030 r. mają wzrosnąć o kolejne 2 bln dolarów.Mimo tego przychody z tzw. inferencji (praktyczne wykorzystanie modeli AI w aplikacjach i usługach) wynoszą obecnie zaledwie 5–10 mld dolarów rocznie. Prezes regionu EMEA Vertiv podkreślał, że nawet 80 proc. danych przedsiębiorstw nadal jeszcze pozostaje poza poza chmurą, co ogranicza dostępność informacji dla dużych modeli językowych (LLM) i stanowi istotną barierę w pełnym wykorzystaniu potencjału AI w biznesie. To wyraźnie pokazuje, że obecny etap rozwoju AI to przede wszystkim faza inwestycyjna, w której sektor buduje fundamenty pod przyszłą skalowalność.

Carlo Ruiz podkreślał, że Nvidia koncentruje się na rozwoju fabryk AI, które są czymś więcej niż tylko kolejnymi dużymi centrami danych, a ich powstawanie należy postrzegać jako nową rewolucję przemysłową. Wskazał również na kolejny etap rozwoju sztucznej inteligencji – fizyczną AI (ang. Physical AI), znajdującą zastosowanie w przemyśle, m.in. w robotyce, systemach wizyjnych, magazynach, fabrykach i innych autonomicznych urządzeniach. W tym obszarze Nvidia opracowała trójpoziomową architekturę obliczeniową, obejmującą trzy kluczowe typy komputerów: do symulacji (Nvidia Omniverse i Cosmos działające na serwerach Nvidia RTX PRO), do wdrażania (Nvidia Jetson AGX Thor) oraz do trenowania modeli AI (Nvidia DGX AI Supercomputers).

Pod koniec października Vertiv ogłosił rozszerzenie współpracy z Nvidia nad rozwojem infrastruktury zasilania 800 VDC, kluczowej dla przyszłych fabryk AI. Premiera nowych platform planowana jest na drugą połowę 2026 r., jako przygotowanie do debiutu superkomputerowego GPU nowej generacji Nvidia Rubin Ultra (następca architektury Blackwell) w 2027 r. W sierpniu Vertiv zaprezentował OneCore – skalowalne, prefabrykowane rozwiązanie infrastrukturalne dla środowisk AI i HPC o gęstości powyżej 5 MW. We wrześniu firma wprowadziła moduły dystrybucji zasilania Vertiv PowerIT, obsługujące do 57,6 kW na szafę serwerową.

Karsten Winther, prezes regionu EMEA, poinformował, że z dniem 31 grudnia 2025 r. przechodzi na emeryturę. Na konferencji we Włoszech przedstawił swojego następcą - Paula Ryana, obecnie dyrektor ds. zaopatrzenia w Vertiv, z ponad 20-letnim doświadczeniem w branży.